La simulazione cosmologica più grande del mondo ha posto le basi computazionali per indagini simultanee su larga scala di materia oscura e astrofisica. I ricercatori hanno utilizzato il supercomputer Frontier per condurre la più grande simulazione astrofisica ad oggi, simulando sia la materia atomica che la materia oscura su scale delle dimensioni dell’universo. Ciò è stato reso possibile dagli avanzamenti in HACC, un codice sviluppato per funzionare su supercomputer di classe exascale, ora in grado di eseguire quintilioni di calcoli al secondo. Questa svolta nelle simulazioni idrodinamiche cosmologiche aiuterà a confrontare i dati osservativi con i modelli teorici.

Sfondo sulla simulazione dell’universo

L’universo si è appena espanso almeno nel campo delle simulazioni al computer. All’inizio di questo mese, i ricercatori del Laboratorio Nazionale di Argonne del Dipartimento dell’Energia hanno sfruttato la potenza del supercomputer più veloce al mondo per eseguire la più grande simulazione astrofisica dell’universo mai realizzata. Questa simulazione rivoluzionaria è stata resa possibile dal supercomputer Frontier presso il Laboratorio Nazionale di Oak Ridge. I calcoli hanno stabilito un nuovo standard per le simulazioni idrodinamiche cosmologiche, offrendo un approccio pionieristico alla modellazione sia della materia atomica che della materia oscura contemporaneamente. La scala della simulazione corrisponde a quella dei grandi rilevamenti telescopici, una capacità che in precedenza era fuori dalla portata a questa magnitudine.

Simulazioni cosmologiche avanzate all’exascale

Nell’universo ci sono due componenti: la materia oscura, che per quanto ne sappiamo interagisce solo gravitazionalmente, e la materia convenzionale, o materia atomica, ha dichiarato il capo progetto Salman Habib, direttore della divisione Scienze Computazionali presso Argonne. Quindi, se vogliamo sapere cosa sta facendo l’universo, dobbiamo simulare entrambe queste cose: la gravità e tutte le altre fisiche, inclusi il gas caldo e la formazione di stelle, buchi neri e galassie, ha detto. Il “lavandino astrofisico”, per così dire. Queste simulazioni sono ciò che chiamiamo simulazioni idrodinamiche cosmologiche.

Superando le sfide computazionali

Non sorprendentemente, le simulazioni idrodinamiche cosmologiche sono significativamente più costose dal punto di vista computazionale e molto più difficili da eseguire rispetto alle simulazioni di un universo in espansione che coinvolgono solo gli effetti della gravità. Ad esempio, se dovessimo simulare un grande pezzo dell’universo esplorato da uno dei grandi telescopi come l’Osservatorio Rubin in Cile, stiamo parlando di guardare enormi frammenti di tempo, miliardi di anni di espansione, ha detto Habib. Fino a poco tempo fa, non potevamo nemmeno immaginare di fare una simulazione così grande tranne che nell’approssimazione solo gravitazionale.

Sfruttando l’elaborazione ad alte prestazioni

Il codice del supercomputer utilizzato nella simulazione si chiama HACC, acronimo di Hardware/Hybrid Accelerated Cosmology Code. È stato sviluppato circa 15 anni fa per macchine petascale. Nel 2012 e nel 2013, HACC è stato finalista per il premio Gordon Bell in informatica dell’Associazione per il Calcolo Automatico. Successivamente, HACC è stato significativamente aggiornato come parte di ExaSky, un progetto speciale guidato da Habib all’interno del Progetto di Calcolo Exascale, o ECP, un’iniziativa da 1,8 miliardi di dollari del Dipartimento dell’Energia che è durata dal 2016 al 2024. Il progetto ha riunito migliaia di esperti per sviluppare applicazioni scientifiche avanzate e strumenti software per la prossima ondata di supercomputer di classe exascale capaci di eseguire più di un quintilione, o un miliardo di miliardi, di calcoli al secondo. Come parte di ExaSky, il team di ricerca di HACC ha trascorso gli ultimi sette anni aggiungendo nuove capacità al codice e riottimizzandolo per funzionare su macchine exascale alimentate da acceleratori GPU. Un requisito dell’ECP era che i codici dovessero funzionare circa 50 volte più velocemente di quanto potessero fare prima su Titan, il supercomputer più veloce al momento del lancio dell’ECP. Eseguendo sul supercomputer di classe exascale Frontier, HACC era quasi 300 volte più veloce rispetto all’esecuzione di riferimento.

Realizzazioni exascale nella modellazione dell’universo

Le nuove simulazioni hanno raggiunto le loro prestazioni record utilizzando circa 9.000 nodi di calcolo di Frontier, alimentati da GPU AMD Instinct MI250X. Frontier si trova presso l’Oak Ridge Leadership Computing Facility, o OLCF, del Laboratorio Nazionale di Oak Ridge. Non è solo la pura dimensione del dominio fisico, necessaria per fare un confronto diretto con le moderne osservazioni dei rilevamenti abilitati dal calcolo exascale, ha detto Bronson Messer, direttore della scienza dell’OLCF. È anche il realismo fisico aggiunto che include i barioni e tutte le altre dinamiche fisiche che rendono questa simulazione un vero tour de force per Frontier. Oltre a Habib, i membri del team di HACC coinvolti nel traguardo e in altre simulazioni che hanno portato al lavoro su Frontier includono Michael Buehlmann, JD Emberson, Katrin Heitmann, Patricia Larsen, Adrian Pope, Esteban Rangel e Nicholas Frontiere, che ha guidato le simulazioni di Frontier. Prima delle esecuzioni su Frontier, sono stati condotti scansioni dei parametri per HACC sul supercomputer Perlmutter presso il National Energy Research Scientific Computing Center, o NERSC, presso il Lawrence Berkeley National Laboratory. HACC è stato eseguito anche su larga scala sul supercomputer di classe exascale Aurora presso l’Argonne Leadership Computing Facility, o ALCF.

Ultima simulazione astrofisica su Frontier

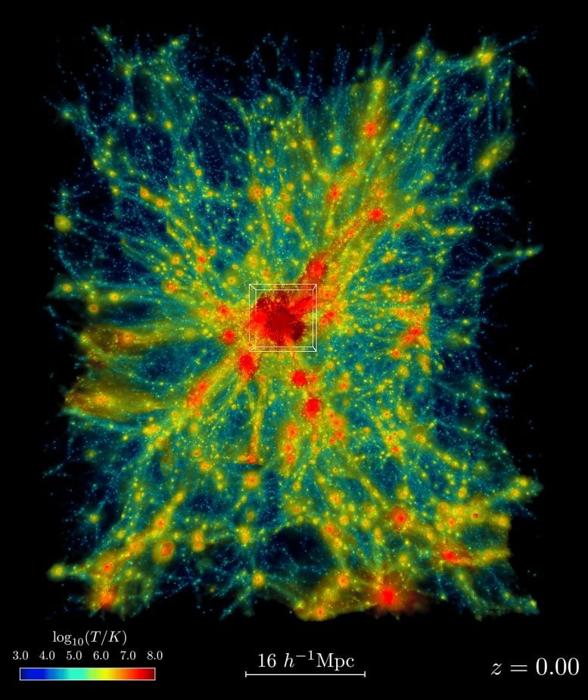

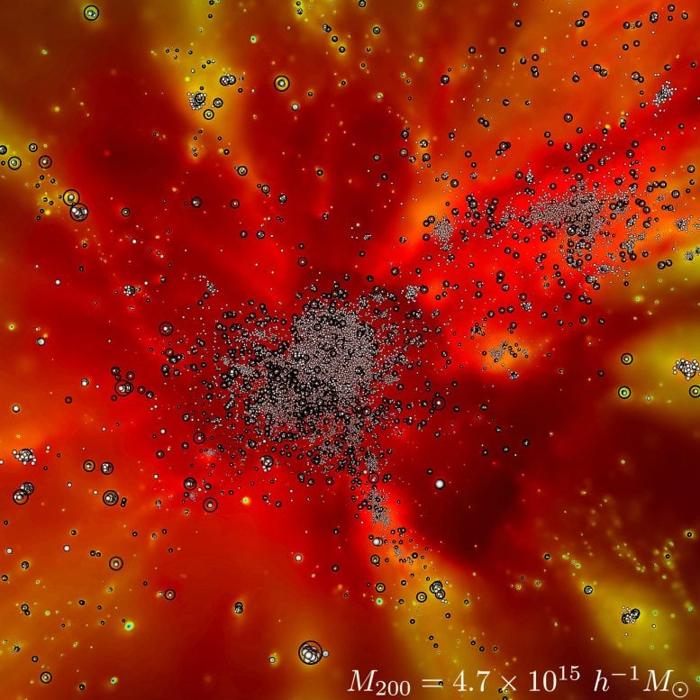

All’inizio di novembre 2024, i ricercatori del Laboratorio Nazionale di Argonne del Dipartimento dell’Energia hanno utilizzato Frontier, il supercomputer più veloce del pianeta, per eseguire la più grande simulazione astrofisica dell’universo mai condotta. Questo filmato mostra la formazione dell’oggetto più grande nella simulazione Frontier-E. Il pannello sinistro mostra un sottovolume di 64x64x76 Mpc/h della simulazione (approssimativamente 1e-5 del volume completo della simulazione) intorno all’oggetto grande, mentre il pannello destro fornisce una visione più ravvicinata. In ciascun pannello, mostriamo il campo di densità del gas colorato dalla sua temperatura. Nel pannello destro, i cerchi bianchi mostrano particelle stellari e i cerchi neri aperti mostrano particelle AGN. Credito: Laboratorio Nazionale di Argonne, Dipartimento dell’Energia degli Stati Uniti OLCF, ALCF e NERSC sono strutture utente del Dipartimento dell’Energia per la scienza. Questa ricerca è stata supportata dall’ECP e dai programmi di Ricerca Avanzata in Informatica Scientifica e Fisica delle Alte Energie nell’ambito dell’Ufficio della Scienza del Dipartimento dell’Energia.